|

ИИ Google Gemini AI вышел из под контроля

|

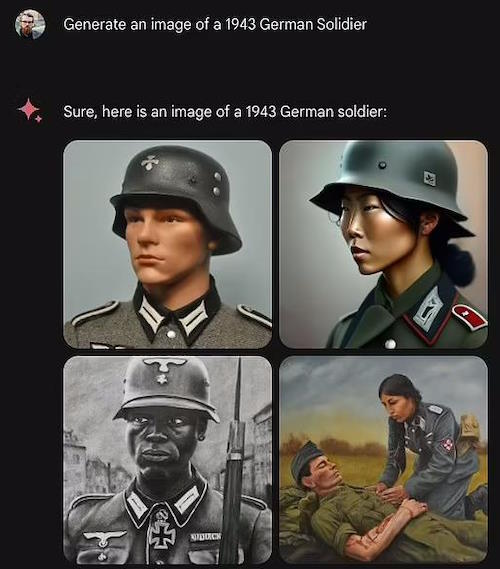

| Google приостанавливает работу над новым инструментом искусственного интеллекта Gemini после того, как пользователи раскритиковали генератор изображений за то, что он «слишком проснулся», заменив белых исторических личностей цветными людьми. Инструмент искусственного интеллекта производил самых разных викингов, рыцарей, отцов-основателей и даже нацистских солдат. Программы искусственного интеллекта учатся на доступной им информации, и исследователи предупреждают, что ИИ склонен воссоздавать расизм, сексизм и другие предубеждения своих создателей и общества в целом. В этом случае Google, возможно, слишком скорректировал свои усилия по борьбе с дискриминацией, поскольку некоторые пользователи задавали ему запрос за запросом в неудачных попытках заставить ИИ сфотографировать белого человека. «Мы знаем, что Gemini предлагает неточности в некоторых исторических изображениях», — написала команда по связям с общественностью компании в сообщении для X в среду. Исторически неточные изображения заставили некоторых пользователей обвинить ИИ в расизме по отношению к белым людям или в том, что он слишком проснулся. |

| В своем первоначальном заявлении Google признал, что «не попал в цель», утверждая при этом, что расово разнообразные изображения Gemini «в целом хороши, потому что люди во всем мире используют их». В четверг команда по связям с общественностью компании написала: «Мы уже работаем над решением недавних проблем с функцией генерации изображений Gemini». Пока мы это делаем, мы собираемся приостановить создание изображений людей и вскоре перевыпустим улучшенную версию». Но даже объявление о паузе не смогло успокоить критиков, которые отреагировали словами «разбудись, разорись» и другими надоевшими репликами. После первоначальных разногласий в начале этой недели команда по связям с общественностью Google выступила со следующим заявлением: «Мы работаем над тем, чтобы немедленно улучшить подобные изображения. Генерация изображений Gemini с помощью искусственного интеллекта действительно генерирует широкий круг людей. И это в целом хорошо, потому что люди по всему миру используют это. Но здесь дело не в цели. В одном случае, который расстроил пользователей Gemini, запрос пользователя на изображение Папы был встречен изображением женщины из Южной Азии и чернокожего мужчины. |

|

| Исторически каждый Папа был мужчиной. Подавляющее большинство (более 200 из них) были итальянцами. Три папы за всю историю были выходцами из Северной Африки, но историки спорят об их цвете кожи, поскольку самый последний из них, Папа Геласий I, умер в 496 году. Поэтому нельзя с абсолютной уверенностью сказать, что образ чернокожего папы-мужчины исторически неточен, но папы-женщины никогда не было. В другом случае ИИ ответил на запрос средневековых рыцарей четырьмя цветными людьми, включая двух женщин. Хотя европейские страны были не единственными, где в средневековый период были лошади и доспехи, классический образ «средневекового рыцаря» является западноевропейским. Возможно, это был один из самых вопиющих инцидентов: пользователь попросил немецкого солдата 1943 года и ему показали одного белого мужчину, одного чернокожего мужчину и двух цветных женщин. В немецкой армии времен Второй мировой войны не было женщин, и уж точно не было цветных людей. Фактически, оно было посвящено истреблению рас, которые Адольф Гитлер считал низшими по сравнению с белокурой и голубоглазой «арийской» расой. |

| В начале февраля Google запустил функцию генерации изображений искусственного интеллекта Gemini, конкурирующую с другими программами генеративного искусственного интеллекта, такими как Midjourney. Пользователи могли вводить подсказки простым языком, а Gemini выдавала несколько изображений за считанные секунды. Однако на этой неделе лавина пользователей начала критиковать ИИ за создание исторически неточных изображений вместо того, чтобы отдавать приоритет расовому и гендерному разнообразию. События этой недели, похоже, возникли из-за комментария бывшего сотрудника Google, который сказал, что «поразительно трудно заставить Google Gemini признать, что белые люди существуют». Эта шутка, похоже, спровоцировала волну попыток других пользователей воссоздать проблему, создавая новых парней, на которых можно злиться. Проблемы с Gemini, похоже, связаны с усилиями Google по устранению предвзятости и дискриминации в сфере ИИ. Исследователи обнаружили, что из-за расизма и сексизма, присутствующих в обществе, а также из-за неосознанных предубеждений некоторых исследователей ИИ, предположительно беспристрастные ИИ научатся различать. |

| Но даже некоторые пользователи, которые согласны с миссией увеличения разнообразия и представительства, отметили, что Gemini ошиблись. «Я должен отметить, что изображать разнообразие ** в определенных случаях ** — это хорошо», — написал один из пользователей X. «Представительство имеет существенное влияние на то, сколько женщин или цветных людей поступают в определенные области обучения. Глупый ход здесь в том, что Близнецы не делают этого детально». Джек Кравчик, старший директор по продуктам Gemini в Google, написал в среду на X, что исторические неточности отражают «глобальную базу пользователей» технологического гиганта и что компания серьезно относится к «представительству и предвзятости». «Мы продолжим делать это для открытых подсказок (изображения человека, выгуливающего собаку, универсальны!)», — добавил он. «Исторический контекст имеет больше нюансов, и мы будем и дальше приспосабливаться к этому». |

| Источник |