|

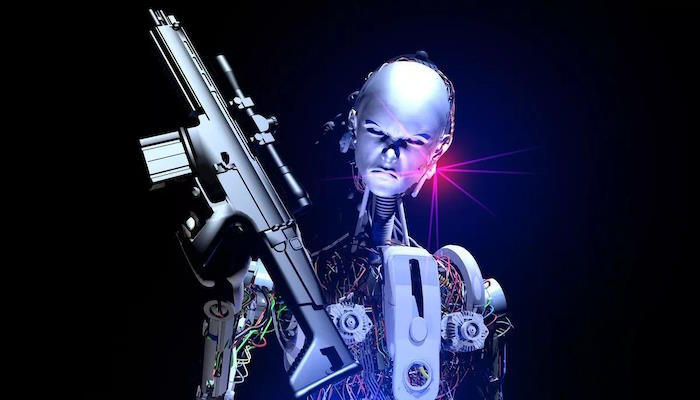

Роботы небезопасны и могут нанести вред обществу

|

| «Совершенно безрассудные» технологические гиганты, выпускающие все более мощных ботов до того, как человечество узнает, как «обезопасить их», должны нести ответственность за любой причиненный ими вред в стиле Терминатора, говорят ученые. По мнению множества экспертов, в том числе двух «крестных отцов» технологии, мощные системы искусственного интеллекта могут разрушить общество. По мнению экспертов, крупные технологические компании, которые игнорируют опасности, должны нести ответственность за ущерб, который наносят их боты. Призыв прозвучал накануне саммита по безопасности искусственного интеллекта в Блетчли-Парке, который состоится на следующей неделе, в котором примут участие международные политики, технологические фирмы и ученые. Стюарт Рассел, профессор информатики Калифорнийского университета в Беркли, США, стал соавтором политического предложения 23 экспертов, критикующих продолжение производства более мощного ИИ до тех пор, пока они не придумают, как остановить ботов, сеющих хаос. |

|

| Он сказал, что «сэндвич-магазины» сталкиваются с более жестким регулированием, чем технологические гиганты. «Пришло время серьезно отнестись к передовым системам искусственного интеллекта», — сказал он. «Это не игрушки. Увеличивать их возможности до того, как мы поймем, как сделать их безопасными, крайне безрассудно. «В отношении магазинов сэндвичей действует больше правил, чем в отношении компаний, занимающихся искусственным интеллектом». Документ призывает правительства принять ряд мер, включая выделение одной трети финансирования исследований в области искусственного интеллекта, а компаниям — треть своих ресурсов на безопасное и этичное использование систем. Независимым аудиторам должен быть разрешен доступ в лаборатории. Передовые боты должны быть лицензированы до их создания. Компании, занимающиеся искусственным интеллектом, должны принять особые меры безопасности, если в их системах обнаружены опасные возможности. И все технологические компании должны нести ответственность за предсказуемый и предотвратимый ущерб, причиняемый их системами. |

| Соавторами документа являются Джеффри Хинтон и Йошуа Бенджио, двое из трёх «крестных отцов искусственного интеллекта», получивших премию Тьюринга ACM — эквивалент Нобелевской премии в области компьютерных наук — в 2018 году. Хинтон покинул Google в этом году, чтобы предупредить о том, что он назвал «экзистенциальным риском», создаваемым цифровым интеллектом. Бенджио, профессор информатики Монреальского университета (Канада), присоединился к нему и тысячам других экспертов, подписавших в марте письмо с призывом приостановить гигантские эксперименты по искусственному интеллекту. Авторы отчета предупредили, что небрежно разработанные боты угрожают «усилить социальную несправедливость, подорвать наши профессии, подорвать социальную стабильность, сделать возможным крупномасштабную преступную или террористическую деятельность и ослабить наше общее понимание реальности, которое является основополагающим для общества». Они заявили, что ИИ уже демонстрирует признаки тревожных возможностей, которые вскоре могут привести к появлению автономных систем, которые смогут планировать, преследовать цели и «действовать в мире». |

| По словам экспертов, модель искусственного интеллекта GPT-4, лежащая в основе инструмента ChatGPT, разработанного американской фирмой OpenAI, может разрабатывать и проводить химические эксперименты, просматривать веб-страницы и использовать программные инструменты, включая других ботов. «Если мы создадим высокоразвитый автономный ИИ, мы рискуем создать системы, которые автономно преследуют нежелательные цели», — заявили они. Другие рекомендации включают обязательное информирование об инцидентах, когда боты демонстрируют тревожное поведение, меры по предотвращению самовоспроизведения опасных моделей и предоставление регулирующим органам полномочий останавливать разработку опасных систем. Саммит на следующей неделе будет посвящен экзистенциальным угрозам, исходящим от ИИ, таким как помощь в разработке биологического оружия и уклонение от контроля со стороны человека. Некоторые эксперты утверждают, что угроза для людей преувеличена. Янн ЛеКун, главный научный сотрудник ИИ в Meta, сказал, что идея, что ИИ может истребить людей, «абсурдна». Но авторы политического документа саммита утверждают, что если сейчас появятся передовые автономные системы искусственного интеллекта, мир не будет знать, как сделать их безопасными. |

| Источник |