|

Худшие сценарии развития ИИ

|

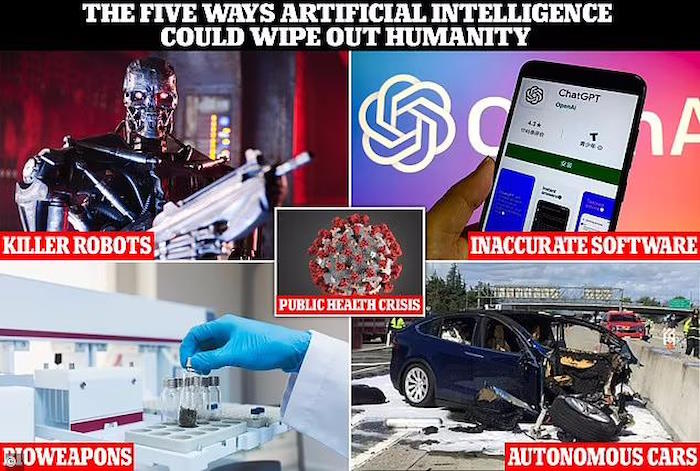

| Серьезное предупреждение об опасностях искусственного интеллекта (ИИ) для человека поступило сегодня от премьер-министра Риши Сунака. Признавая положительный потенциал технологии в таких областях, как здравоохранение, премьер-министр заявил, что «человечество может полностью потерять контроль над ИИ» с «невероятно серьезными» последствиями. Серьезное послание совпадает с публикацией правительственного отчета и предшествует первому в мире саммиту по безопасности ИИ, который пройдет на следующей неделе в Бакингемшире. Многие ведущие ученые мира, присутствовавшие на мероприятии, считают, что в ближайшем будущем эту технологию можно использовать даже для того, чтобы убить нас. Вот пять способов уничтожения людей с помощью ИИ: от разработки нового биологического оружия до автономных автомобилей и роботов-убийц. |

| РОБОТЫ-УБИЙЦЫ |

| Во многом благодаря таким фильмам, как «Терминатор», распространенный сценарий конца света в популярной культуре изображает нашу гибель от рук роботов-убийц. Они, как правило, оснащены оружием и непроницаемыми металлическими экзоскелетами, а также массивными сверхчеловеческими конечностями, которые могут с легкостью раздавить или задушить нас. Натали Крамп, генеральный директор компании Profusion, занимающейся данными, признала, что такая возможность возможна, но, к счастью, это может произойти не при нашей жизни. «Мы далеки от того, чтобы робототехника достигла уровня, когда машины, подобные Терминатору, смогут свергнуть человечество», — сказала она MailOnline. «В будущем возможно все… как мы знаем, ИИ далеко не безошибочен». Такие компании, как Tesla Илона Маска, работают над гуманоидными ботами, предназначенными для помощи по дому, но впереди могут возникнуть проблемы, если они каким-то образом выйдут из строя. |

|

| Марк Ли, профессор Университета Бирмингема, сказал, что роботы-убийцы, такие как Терминатор, «определенно возможны в будущем» из-за «быстрой революции в искусственном интеллекте». Макс Тегмарк, физик и эксперт по искусственному интеллекту из Массачусетского технологического института, считает, что гибель людей может быть просто частью правила, регулирующего жизнь на этой планете – выживает сильнейший. По словам ученого, история показала, что самые умные виды на Земле – люди – несут ответственность за гибель «меньших» видов, таких как дронт. Но если появится более сильный и умный «вид», управляемый искусственным интеллектом, та же участь может легко ожидать нас, предупредил профессор Тегмарк. Более того, мы не будем знать, когда произойдет наша гибель от рук ИИ, потому что менее разумные виды не имеют возможности узнать об этом. Крамп сказал, что более реалистичной формой опасного ИИ в ближайшей перспективе является разработка технологии дронов для военного применения, которой можно было бы управлять дистанционно с помощью ИИ и «предпринимать действия, которые «наносят реальный вред». |

| ПРОГРАММНОЕ ОБЕСПЕЧЕНИЕ |

| Ключевая часть нового правительственного отчета разделяет опасения по поводу «утраты контроля» над важными решениями за счет программного обеспечения на базе искусственного интеллекта. Люди все чаще передают ИИ контроль над важными решениями, будь то опасная ситуация в игре в теннис или что-то более серьезное, например, приговоры в суде, как это видно на примере Китая. Но ситуация может возрасти еще больше, когда люди станут ленивее и захотят передать задачи на аутсорсинг или по мере роста нашей уверенности в способностях ИИ. В новом отчете говорится, что эксперты обеспокоены тем, что «будущие продвинутые системы искусственного интеллекта будут стремиться увеличить свое влияние и уменьшить человеческий контроль, что может привести к катастрофическим последствиям». |

| Даже, казалось бы, безобидное программное обеспечение искусственного интеллекта может принимать решения, которые могут быть фатальными для людей, если технология не запрограммирована с достаточной тщательностью. Программное обеспечение искусственного интеллекта уже широко распространено в обществе: от распознавания лиц на барьерах безопасности до цифровых помощников и популярных онлайн-чат-ботов, таких как ChatGPT и Bard, которых критиковали за выдачу неправильных ответов. «Галлюцинации и ошибки, которые создают генерирующие приложения искусственного интеллекта, такие как ChatGPT и Bard, являются одной из наиболее насущных проблем, с которыми сталкивается развитие ИИ», — сказал Крамп MailOnline. Огромные машины, работающие на базе программного обеспечения искусственного интеллекта, также проникают на фабрики и склады, и их сбои приводят к трагическим последствиям. |

| БИООРУЖИЕ |

| Выступая сегодня в Лондоне, премьер-министр Риши Сунак также выделил химическое и биологическое оружие, созданное с помощью ИИ, как особую угрозу. Исследователи, занимающиеся разработкой лекарств на основе искусственного интеллекта, считают, что террористы могут легко манипулировать этой технологией для поиска токсичных нервно-паралитических веществ. Молекулы могут быть более токсичными, чем VX, нервно-паралитическое вещество, разработанное Лабораторией оборонной науки и технологий Великобритании в 1950-х годах и убивающее путем мышечного паралича. В правительственном отчете говорится, что модели ИИ уже работают автономно, заказывая лабораторное оборудование для проведения лабораторных экспериментов. «Инструменты искусственного интеллекта уже могут генерировать новые белки с отдельными простыми функциями и поддерживать разработку биологических агентов с комбинациями желаемых свойств», — говорится в нем. «Инструменты биологического проектирования часто имеют открытый исходный код, что затрудняет реализацию мер безопасности. |

| АВТОНОМНЫЕ АВТОМОБИЛИ |

| Крамп сказал, что типами ИИ-устройств, которые могут «выйти из-под контроля» и причинить нам вред в ближайшем будущем, скорее всего, будут повседневные объекты и инфраструктура, такие как выход из строя энергосистемы или неисправный беспилотный автомобиль. Беспилотные автомобили используют камеры и устройства LiDAR, чувствительные к глубине, чтобы «видеть» и распознавать мир вокруг них, а их программное обеспечение принимает решения на основе этой информации. Однако малейшая ошибка в программном обеспечении может привести к тому, что беспилотный автомобиль врежется в скопление пешеходов или проедет на красный свет. По данным Министерства транспорта, к 2035 году рынок беспилотных автомобилей в Великобритании будет стоить почти 42 миллиарда фунтов стерлингов – к этому времени 40 процентов продаж новых автомобилей в Великобритании могут иметь возможности беспилотного вождения. Однако широкое распространение автономные транспортные средства смогут получить только в том случае, если можно будет доверять их вождению более безопасно, чем водителям-человекам. |

| Они уже давно застряли на стадиях разработки и тестирования, в основном из-за опасений по поводу их безопасности, о которых уже говорилось. Еще в марте 2018 года женщину из Аризоны Элейн Херцберг насмерть сбил прототип беспилотного автомобиля компании Uber, но с тех пор произошел ряд инцидентов со смертельным исходом и без смертельного исхода, некоторые из которых были связаны с автомобилями Tesla. Генеральный директор Tesla Илон Маск — одно из самых выдающихся имен и лиц, разрабатывающих такие технологии, и он невероятно откровенен, когда речь идет о возможностях искусственного интеллекта. В марте Маск и тысяча других технологических лидеров призвали приостановить «опасную гонку» по разработке ИИ, которая, как они опасаются, представляет «серьезный риск для общества и человечества» и может иметь «катастрофические» последствия. |

| КРИЗИС ОБЩЕСТВЕННОГО ЗДРАВООХРАНЕНИЯ |

| Согласно правительственному отчету, еще одним реальным вредом, причиненным ИИ в ближайшем будущем, является «усугубление кризиса общественного здравоохранения». Без надлежащего регулирования платформы социальных сетей, такие как Facebook, и инструменты искусственного интеллекта, такие как ChatGPT, могут способствовать распространению дезинформации о здоровье в Интернете. Это, в свою очередь, может помочь микроорганизму-убийце размножаться и распространяться, потенциально убивая больше людей, чем Covid. В докладе цитируется исследовательский документ 2020 года, в котором обвиняется в бомбардировке информацией из «ненадежных источников» людей, игнорирующих рекомендации общественного здравоохранения и способствующих распространению коронавируса. Если ИИ действительно убивает людей, то маловероятно, что это произойдет потому, что их сознание по своей сути является злом, и тем более, что дизайнеры людей не учли недостатки. «Когда мы думаем об ИИ, важно помнить, что мы далеки от того, чтобы ИИ действительно «думал» или был разумным», — сказал Крэмп MailOnline. |

| «Приложения вроде ChatGPT могут создавать видимость мысли, и многие из их результатов могут показаться впечатляющими, но они не делают ничего, кроме обработки и анализа данных с помощью алгоритмов. «Если эти алгоритмы плохо спроектированы или данные, которые они используют, каким-то образом предвзяты, вы можете получить нежелательные результаты. «В будущем мы можем прийти к моменту, когда ИИ будет соответствовать всем критериям, которые составляют осведомленность и независимое, обдуманное мышление, и, если мы не встроим надежные меры защиты, мы можем обнаружить, что он совершает очень вредные или непредсказуемые вещи. «Вот почему так важно сейчас серьезно обсудить регулирование ИИ и очень тщательно подумать о том, как мы хотим, чтобы ИИ развивался с этической точки зрения». Профессор Ли из Бирмингемского университета согласился, что основные проблемы ИИ связаны с программным обеспечением, а не с робототехникой, особенно с чат-ботами, которые используют большие языковые модели (LLM), такие как ChatGPT. «Я уверен, что мы увидим и другие разработки в области робототехники, но сейчас я думаю, что настоящие опасности по своей природе таятся в Интернете», — сказал он MailOnline. «Например, LLM могут использоваться террористами, например, для обучения созданию бомб или биохимических угроз». |

| Источник |