|

ИИ может помочь астрономам быстро генерировать гипотезы

|

| Почти везде, где бы вы ни находились в Интернете, почти невозможно избежать статей об ИИ. Даже здесь, в UT, мы опубликовали несколько. Обычно они сосредотачиваются на том, как конкретная исследовательская группа использовала технологию для осмысления множества данных. Но такое распознавание образов — не все, для чего хорош ИИ. На самом деле, он становится довольно способным к абстрактному мышлению. И одно место, где абстрактное мышление может быть полезным, — это разработка новых научных теорий. Помня об этом, группа исследователей из ЕКА, Колумбии и Австралийского национального университета (ANU) использовала ИИ для выдвижения научных гипотез в астрономии. В частности, они сделали это в области галактической астрономии, которая специализируется на исследованиях, связанных с формированием и физикой галактик. В недавно опубликованной статье на сервере препринтов arXiv упоминается, что они выбрали это подполе из-за его «интегративного характера», который требует «знаний из различных подполей». |

|

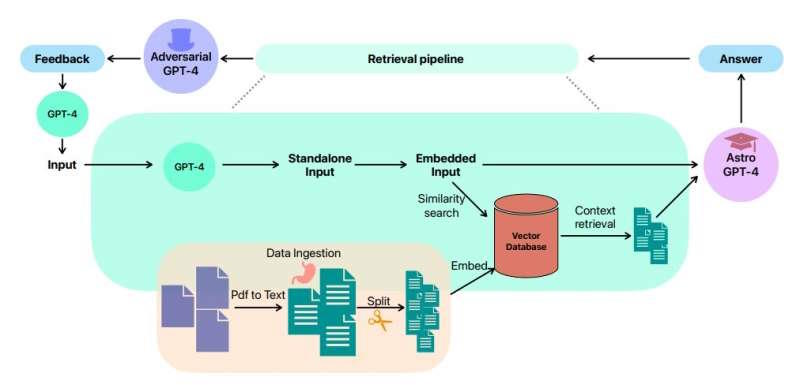

| Это похоже на то, в чем ИИ уже хорош. Но стандартная большая языковая модель (LLM), подобная тем, которые стали наиболее привычными в последнее время (ChatGPT, Bard и т. д.), не обладала бы достаточными предметными знаниями для разработки разумных гипотез в этой области. Он может даже стать жертвой «галлюцинаций», которые, как предупреждают некоторые исследователи (и журналисты), являются одним из недостатков взаимодействия с моделями. Чтобы избежать этой проблемы, исследователи под руководством Иоаны Чукэ и Юань-Сен Тинга из ANU использовали фрагмент кода, известный как интерфейс прикладного программирования (API), который был написан на Python и известен как Langchain. Этот API позволяет более продвинутым пользователям манипулировать LLM, такими как GPT-4, который служит последней основой для ChatGPT. В случае исследователей они загрузили более 1000 научных статей, касающихся галактической астрономии, в GPT-4 после загрузки их из системы астрофизических данных НАСА. |

| Один из экспериментов исследователей заключался в том, чтобы проверить, как количество статей, к которым модель имела доступ, повлияла на ее итоговые гипотезы. Они заметили значительную разницу между предложенными гипотезами, которые были разработаны при доступе только к десяти статьям, и при наличии доступа к полной тысяче. Но как они судили о справедливости самих гипотез? Они сделали то, что сделал бы любой уважающий себя ученый, и наняли экспертов в этой области. Два из них, если быть точным. И они просили их только гипотезы, основанные на оригинальности мысли, возможности проверки гипотезы и научной точности ее основы. Эксперты обнаружили, что даже с ограниченным набором данных, состоящим всего из десяти статей, гипотезы, предложенные Astro-GPT, как они назвали свою модель, были оценены лишь немного ниже, чем у компетентного кандидата наук. студент. Получив доступ к полной 1000 статей, Astro-GPT получила «почти экспертный уровень». |

| Решающим фактором в определении окончательных гипотез, которые были представлены экспертам, было то, что гипотезы были уточнены с использованием «состязательных подсказок». Хотя это звучит агрессивно, это просто означает, что в дополнение к программе, которая вырабатывала гипотезы, другая программа была обучена на том же наборе данных, а затем предоставила отзыв первой программе о своих гипотезах, тем самым вынудив исходную программу улучшить свои гипотезы. логические ошибки и, как правило, создают значительно лучшие идеи. Даже с враждебной обратной связью нет причин для доктора астрономии. студенты отказываются от собственных уникальных идей в своей области. Но это исследование действительно указывает на недоиспользованную способность этих LLM. По мере того, как они получают все более широкое распространение, ученые и неспециалисты могут использовать их все больше и больше, чтобы выдвигать новые и лучшие идеи для проверки. |

| Источник |