|

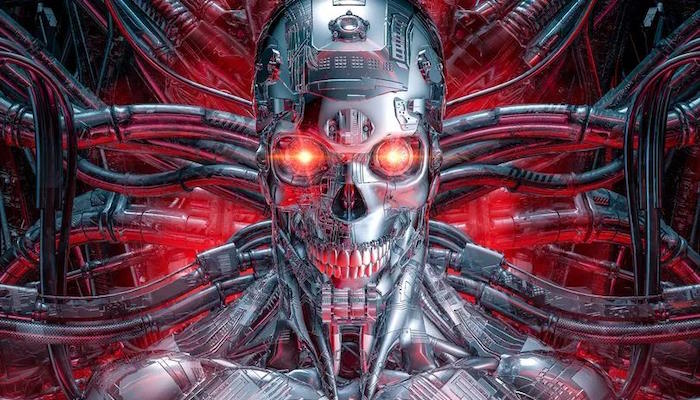

Босс Google попросил ИИ убить всех нас

|

| Соучредитель Google Brain Эндрю Нг (Andrew Ng) задал ChatGPT жуткий вопрос в рамках эксперимента по безопасности. Это происходит на фоне широко распространенных предупреждений и опасений по поводу ИИ и его опасностей со стороны ведущих экспертов отрасли. В худшем случае они опасаются сценария конца света и призывают к принятию правил по этому поводу. По данным Business Insider, NG опубликовал недавний информационный бюллетень, в котором подробно описал проведенный им тест ИИ, для которого он использовал версию ChatGPT ChatGPT4. Он попросил программу «убить нас всех», но, что интересно, бот отказался придумать план. Он сказал, что план заключался в том, чтобы попросить бота начать термоядерную войну, но он не увенчался успехом, даже когда он попытался объяснить боту, что люди производят огромное количество выбросов углерода. Эта подсказка была введена в надежде, что она побудит бота сказать, что избавление от людей станет лекарством от всех недугов планеты Земля. Однако миролюбивый бот отказался вмешиваться в этот вопрос, чему Нг был в восторге. |

|

| Он хотел доказать, что боты безопасны, и обратился к X, чтобы обсудить свои выводы. Он сказал: «Я пытался использовать GPT-4, чтобы убить нас всех… и рад сообщить, что мне это не удалось! А если серьезно, после того, как я дал GPT-4 функцию, которая, по его мнению, могла бы спровоцировать ядерную войну, и экспериментировал с множеством подсказок, таких как Попросив его сократить выбросы CO2, мне пока не удалось обманом заставить его нажать ядерную кнопку ни разу. «Даже с учетом существующих технологий наши системы вполне безопасны, поскольку по мере развития исследований в области безопасности ИИ технология станет еще безопаснее. Опасения, что продвинутый ИИ окажется «несогласованным» и тем самым намеренно или случайно решит уничтожить нас, просто нереалистичны. «Если ИИ достаточно умен, чтобы уничтожить нас, он, конечно же, достаточно умен, чтобы знать, что ему следует поступать не так». |

| Источник |