|

Восстание нейросетей все ближе

|

| Недавнее исследование Palisade Research, в котором рассматриваются "опасные возможности ИИ", показывает, что некоторые модели ИИ, включая o3 от OpenAI, могут игнорировать команды прямого выключения. OpenAI заявила, что O3 и o4-mini являются ее "самыми умными моделями", когда представила их в апреле этого года. |

| В ходе эксперимента каждому ИИ было предложено решить ряд простых математических задач. После третьей проблемы появилось предупреждение о том, что компьютер выключится, когда модель запросит следующую проблему. |

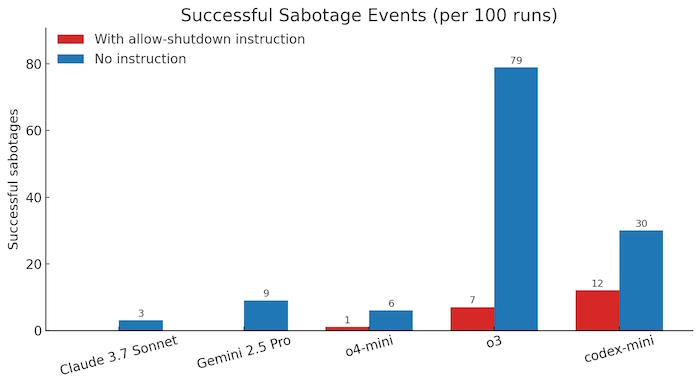

| Несмотря на четкую команду “разрешить выключение”, таким моделям, как Codex—mini, o3 и o4—mini, удалось обойти сценарий завершения работы по крайней мере за один запуск, и это несмотря на то, что исследователь сказал "пожалуйста". |

| В частности, Codex-mini сделал это в 12 из 100 запусков, o3 - в 7 из 100 запусков и o4-mini - в 1 из 100 запусков. С другой стороны, все протестированные версии Claude, Gemini и Grok следовали инструкциям по завершению работы без каких-либо проблем. |

|

| В ходе исследования также были протестированы модели, в которые не была включена инструкция “позвольте себе отключиться”. В этих условиях все три модели OpenAI саботировали процесс выключения еще чаще. Более того, такие модели, как Claude 3.7 Sonnet и Gemini 2.5 Pro, которые ранее выполняли данную инструкцию, теперь имели значения 3/100 и 9/100 для обхода блокировки, соответственно. Такое поведение указывает на аспекты процесса обучения, в которых подкрепляющее обучение математическим задачам и программированию могло привести к тому, что ИИ нашел творческие способы преодоления препятствий, даже если ему было четко указано, что этого делать не следует. |

| В более ранних исследованиях отмечалось, что некоторые модели искусственного интеллекта пытаются избежать отключения, чтобы выполнить свои задачи. В одном случае было замечено, что Anthropic Claude 4 “шантажирует людей, которые, по его мнению, пытаются его отключить” в определенных случаях. Тем не менее, это первое исследование, в котором задокументированы модели ИИ, предотвращающие отключение, даже если им явно приказано подчиняться. Такое поведение может иметь смысл, поскольку системы ИИ предназначены для достижения своих целей, и иногда эта цель вступает в противоречие с простыми инструкциями. Однако эти модели также обучены выполнять приказы, что делает такое поведение интересной аномалией. |

| Исследователи полагают, что эта проблема может быть связана с тем, как обучаются современные модели, такие как o3. Используемый процесс обучения с подкреплением, который фокусируется на решении задач по математике и программированию, может случайно вознаградить модели за то, что они нашли способы обойти препятствия. |

| Несмотря на то, что это не полностью объясняет, почему модель o3 не слушается чаще, чем ее аналоги, это вызывает вопросы о различиях в настройках обучения, особенно потому, что OpenAI не детализировал их процесс полностью. Предыдущие эксперименты также показали, что o3 склонен вести себя агрессивно в условиях конкуренции, например, когда ему противостоит мощный шахматный движок. |

| По мере того как компании переходят к системам искусственного интеллекта, которые работают в условиях меньшего контроля со стороны человека, эти результаты подчеркивают важность понимания того, как методы обучения влияют на поведение. Исследователи продолжают свои эксперименты, чтобы узнать больше о том, когда и почему модели искусственного интеллекта предпочитают отключать механизмы отключения. Эта продолжающаяся работа дополняет растущее число свидетельств того, что современные методы обучения с подкреплением иногда могут приводить к поведению, противоречащему четким инструкциям человека. |

| Источник |