|

Роботов поставили в ситуацию морального выбора

|

| Создав для роботов ситуацию этического выбора — кого из двух человек, одновременно попадающих в опасность, надо спасать — ученые выяснили, что больше всего смертей приносит не сам выбор, а слишком долгие размышления машины. О своем эксперименте Алан Винфилд (Alan Winfield) из Бристольской лаборатории робототехники рассказал на конференции по автономным роботам, которая прошла 2 сентября в Бирмингеме. Кратко об исследовании сообщается в интернет-издании New Scientist. |

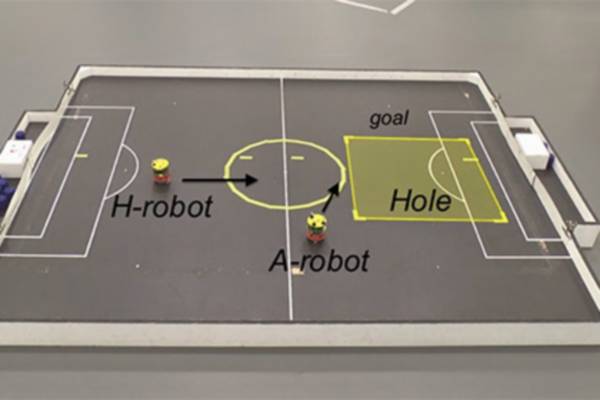

| Винфилд запрограммировал робота удерживать другие автоматы (которые изображали людей) от падения в яму. Такой эксперимент представляет собой, по сути, иллюстрацию к первому закону робототехники А. Азимова: «Робот не может причинить вред человеку или своим бездействием допустить, чтобы человеку был причинен вред». |

|

| Сначала у машины проблем не возникло: как только «человек» приближался к яме, робот быстро отодвигал его от опасного места. Но когда ученые добавили второй автомат, приближавшейся к ловушке с той же скоростью, перед роботом встала дилемма — кого спасать первым. Иногда ему удавалось удержать одного «человека», пару раз — двоих, но в 14 случаев из 33 робот столько времени тратил на этические размышления, что оба «человека» падали в яму, для проверки двигательных навыков роботов ученым потребовался песок. |

| Винфилд признает неутешительные результаты своего эксперимента и подчеркивает, что роботы все еще остаются «этическими зомби»: они, способны соблюдать определенный кодекс поведения, но не понимают его моральные основания. |

| Научить машины принимать этические решения могут специалисты по военной робототехнике. Рональд Аркин (Ronald Arkin) из разработал набор алгоритмов («этический руководитель»), который призван помочь роботам действовать на поле боя: в каких ситуациях прекращать огонь, в какой обстановке (около школы или больницы, например) стремится свести к минимуму количество жертв. |

| Аркин считает, что научить морали военных роботов будет проще всего, так как законы войны являются четкими и прописаны в международных договорах. В отличие от живых солдат, подверженных эмоциям и аффектам, машины никогда не нарушат эти законы. |

| http://lenta.ru/news/2014/09/15/robotsethic/ |